AI早已有之,但无论是深蓝在国际象棋上战胜卡斯帕罗夫,还是AlphaGo在围棋上击败柯洁,都没有像ChatGPT这样引发全民热潮。

正是这一波AIGC(生成式AI),第一次让AI来到了每一个普通人的身边,真正改变了人们的日常生活、工作,而不再是一个高大上的科技概念。

如今无论是互联网厂商还是传统科技厂商,无论是手机厂商还是PC厂商,无论是芯片硬件厂商还是软件厂商,自家产品不搞点AI,都不好意思和人打招呼。

当然了,对于如今人们的生活和工作来说,最核心的设备一是智能手机,二是PC电脑,它们也都在AI的路上衔枚疾进,很多人也经常正路,PC AI和手机AI,究竟哪个才是王道?

首先公平地讲,PC AI和手机AI无所谓孰优孰劣,关键是谁更适合用在哪里。

另一方面,对于AI而言,最基础的前提一是算力是否够强大、模型和算法是否够丰富,二就是应用场景是否够广泛、灵活。

无需赘言,手机和PC相比无论CPU性能还是GPU性能,根本不在一个档次,即便加入独立的AI引擎,也是看不见尾灯的。

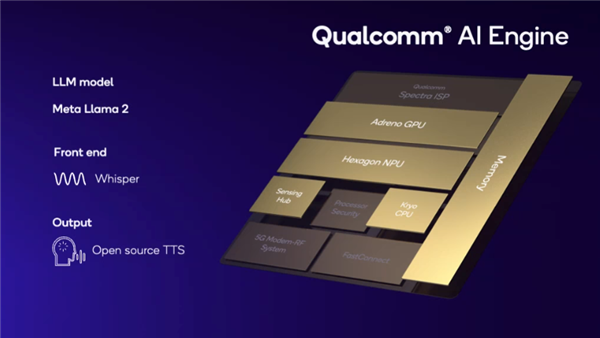

最新发布的高通骁龙8 Gen3已经升级为第九代AI引擎,甚至将Hexagon DSP数字信号处理器升级为专门的NPU神经网络单元,并结合整个平台不同模块的力量,AI性能比上代几乎翻番。

但即便如此,它也只能处理100亿参数的大语言模型,每秒执行Token的数量最多不过20个。

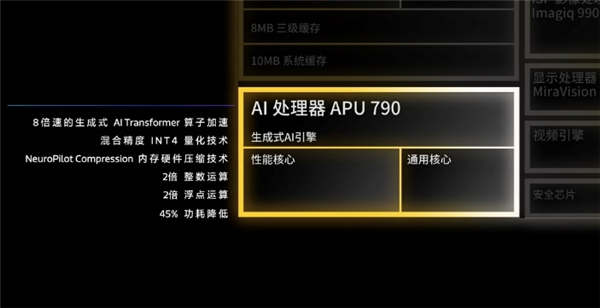

联发科天玑9300配备了第七代APU处理器,具备生成式AI引擎,但也只是实现了70亿参数大语言模型端侧落地、130亿参数大语言模型端侧运行,70亿参数的生成速度也只有每秒20 Tokens。

更关键的是,手机端硬件平台性能优先,尤其是运行大模型必须的内存容量捉襟见肘,即便是高端配置的16GB也过根本不够用。

为此,联发科不得不动用了各种优化手段,包括内存硬件压缩、LoRA融合、Fusion技能扩充等等,才勉强够用。

在PC端,16GB内存如今已经是最起码的配置,32GB都随处可见,再加上PC处理器的强大算力,这些限制根本就不是事儿。

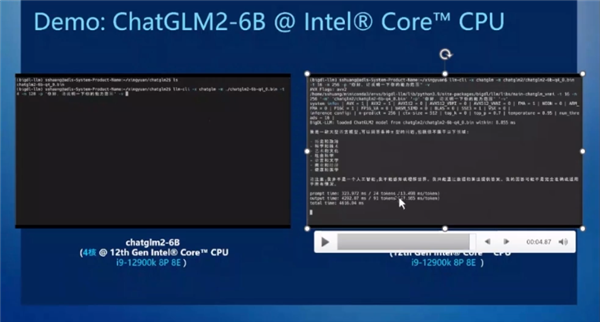

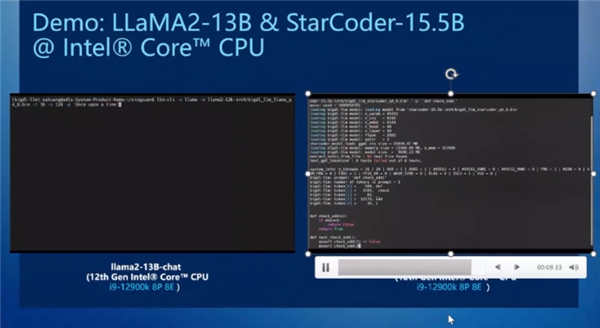

比如Intel 13代酷睿处理器,尚没有独立的AI引擎,但凭借XPU的加速,再加上简单的低比特量化、软件优化,只需16GB内存,就可以通过BigDL-LLM框架,轻松运行160亿参数的大语言模型,还可以快速对接新兴模型,包括但不限于:LLAMA/LLAMA2、ChatGLM/ChatGLM2、MPT、Falcon、MOSS、Baichuan、QWen、Dolly、RedPajama、StarCoder、Whisper,等等。

这里说的BigDL-LLM,是专门针对Intel硬件的一个低比特量化设计开源框架,支持INT3、INT4、INT5、INT8等各种低比特数据精度,性能更好,内存占用更少。

基于这个框架,使用i9-12900K处理器,只开启4个核心来运行ChatGLM2 60亿参数模型,生成效果就相当迅速,打开全部8个P核、8个E核之后生成速度可达每秒22 Tokens,已经不弱于很多云侧计算。

换言之,无论是需要将全部算力投入AI模型的运算,还是兼顾其他任务,PC端都可以轻松完成。

可以看出,无论哪种情况,Intel PC侧都已经可以很好地完成相应的AI工作,提供令人满意的算力和效率。

当然,60亿参数对于PC处理器来说是小菜一碟,换成LLaMA2 130亿参数大语言模型、StarCoder 155亿参数代码大模型,Intel酷睿处理器也都能获得良好的运行速度。

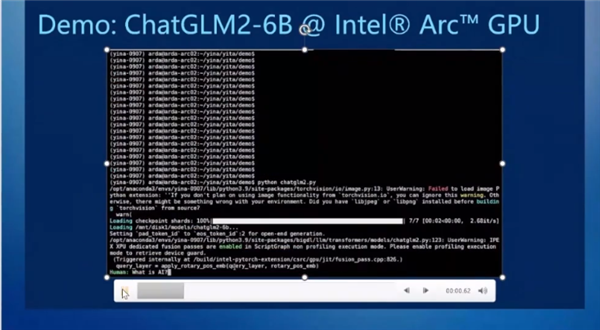

再换成Arc锐炫显卡,速度就更快了,比如ChatGLM2模型中生成速度可以超过每秒50 Tokens。

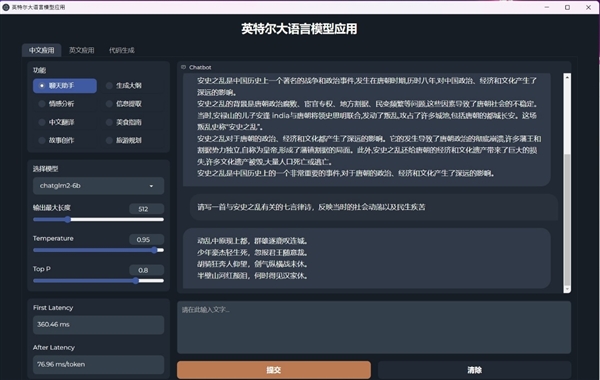

正是得益于如此快速的大语言模型运行速度,即便是一台轻薄笔记本,也可以在日常工作中及时提供各种帮助。

比如包括但不限于:聊天助手、情感分析、中英文翻译、故事创作、生成大纲、信息提取、美食指南、旅游规划、代码生成等等。

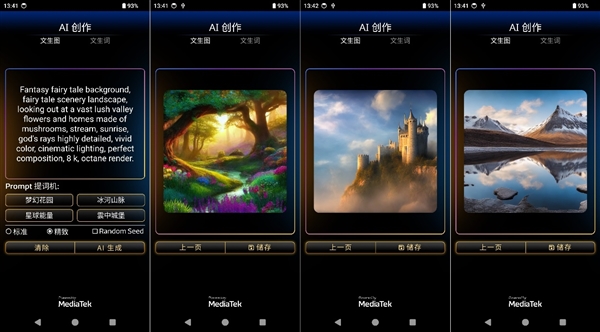

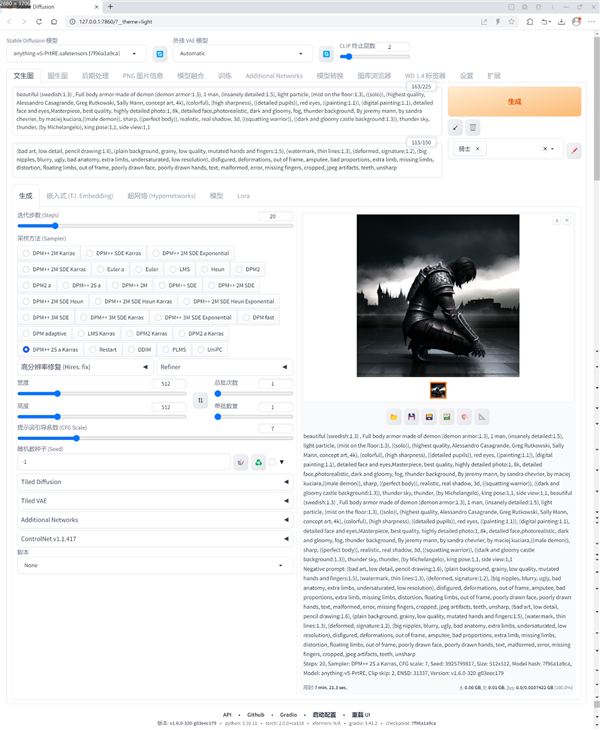

除了基于大语言模型的工作和生活助手,AIGC最常使用的另一个场景就是Stable Diffusion文生图、文胜文,这一点如今无论手机还是PC都可以做到。

当然,还是受制于算力,最新的手机平台虽然号称可以在1秒钟之内完成Stable Diffusion文生图,但是无论生成中的迭代次数、引导系数、关键词数量,还是图片的尺寸、分辨率、质量,都不得不做出妥协,也导致图片的应用范围有限。

在PC上,无论使用CPU还是GPU,完全可以根据自己的需要,任意设定参数,花个几分钟,就能生成用于高级设计、创作的素材。

尤其是在Intel平台上,通过与AI社区积极合作,基于OpenVINO PyTorch后端的方案,可以通过Pytorch API让社区开源模型很好地运行在Intel客户端处理器、集成显卡、独立显卡、专用AI引擎之上。

Stable Diffusion中更是实现了Automatic1111 WebUI,以及FP16的高精度,无论文生图、图生图还是局部修复,都可以获得更好的体验。

事实上,如今已经有很多设计师、UP主开始在PC和工作站上使用Stable Diffusion生成所需要的高质量素材,得到精美的CG动画、模型等等,从而节省大量的精力和时间,将更多头脑投入在创作阶段。

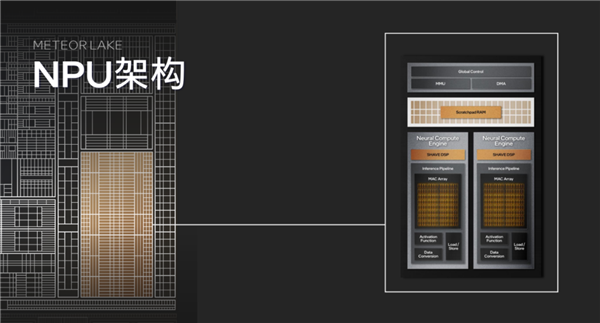

接下来的酷睿Ultra,更是将引入全新升级的CPU/GPU架构,以及全新的NPU AI独立引擎。

它通过单独设置的神经计算引擎、推理流水线,彻底接手端侧的AI推理负载,其中MAC阵列可以高效执行矩阵算法和卷积运算,每周期效率多达2048。

这样的性能更是手机端望尘莫及的,速度超快的同时功耗更是极低,有利于延长笔记本续航时间。

更进一步,酷睿Ultra AI引擎还可以联合CPU、GPU,共同分担AI负载中的不同工作,各自以最高效率执行,达到整体平台效能的最优化。

总之,无论是手机端还是PC端,AI都是大势所趋,性能会越来越好,模型和算法会越来越精妙,应用场景也会越来越丰富。

对于手机端而言,AIGC可以随时随地应用,也可以实现很好的个性化,有着极佳的灵活性。

但同时也不得不受制于手机平台的性能、算力,也限制了应用场景,尤其是大模型不可能完整地从云端搬到本地,导致能实现的应用和生成速度存在天然局限,即便是在应用最直接、最广泛的AI助手中也是如此,需要更多地走端云合作的路子。

对于PC端而言,性能、算力可以几乎无限制地扩展,能够轻松、完整地运行各种大模型,无论你需要生成的图片多么精致、文字多么复杂,给予一定的时间都可以完成,而且这个时间正在快速缩短,因此在内容生产力的AIGC创作方面,PC仍旧是不二之选。

虽然PC的便捷性不如手机,但如今的笔记本也在快速进化,推动着AIGC的快速演进和普及。

一方面,笔记本做得越来越轻薄、精致,性能却越来越好,比如在Intel Evo严苛认证的多年推动之下,笔记本的综合性能、扩展能力、续航水平都达到了空前的高度,可以长时间、轻负担地随时随地完成工作。

另一方面,笔记本开始有了自己的AI引擎,正快速开启AI PC新时代,尤其是Intel最近启动了声势浩大的AI PC加速计划,鼓励AI创新应用,很快就吸引了100多家ISV软件合作伙伴,开发了300多项AI加速功能,预计到2025年将惠及上亿台PC。